Intelligence augmentée : pourquoi la valeur du travail ne se joue plus sur l’outil

Partagez sur les réseaux sociaux

Le 11 février 2026

Compétences humaines, rigueur intellectuelle et usages réels de l’IA dans les organisations québécoises

Un ébéniste qui consacre 40 à 60 heures par semaine à son métier développe une compréhension intime du matériau. Avec le temps, le geste devient précis, l’erreur anticipée, l’ajustement instinctif. Cette maîtrise ne dépend ni du diplôme initial ni de la sophistication des outils. Elle repose sur une loi simple et immuable : la répétition attentive, dans la durée, produit la compétence. À l’inverse, aucun d’entre nous ne se présenterait comme artisan du bois en y consacrant quelques heures par mois. Bien que cette loi n’a jamais été remise en question dans les métiers manuels, elle devient étonnamment floue lorsqu’il est question de travail intellectuel et, plus récemment, d’intelligence artificielle (IA).

Depuis 2023, l’IA générative s’est installée dans les organisations québécoises à un rythme soutenu. En 2025, plusieurs enquêtes sectorielles indiquent que les fonctions administratives, financières et RH figurent parmi les plus exposées à ces outils. Pourtant, les gains de productivité attendus demeurent inégaux, parfois même imperceptibles.

Le débat public s’est rapidement polarisé autour des plateformes. ChatGPT, Claude, Gemini, Grok. Les comparaisons techniques occupent l’espace médiatique. Les discussions portent sur les limites, les biais, les risques. Cette focalisation rassure, car elle permet d’éviter une question plus inconfortable : pourquoi, à outils comparables, certains professionnels améliorent nettement la qualité de leur travail, alors que d’autres n’observent aucun bénéfice tangible ?

Les données disponibles au Québec montrent une tension persistante entre charge cognitive, attentes de performance et capacité réelle d’absorption des organisations. Selon Statistique Canada, la productivité du travail progresse lentement dans les secteurs de services à forte intensité intellectuelle. L’IA, malgré son potentiel, ne renverse pas cette tendance par simple effet d’adoption.

Un malaise s’installe alors. Certains professionnels perçoivent l’IA comme une menace pour leur légitimité. D’autres l’envisagent comme un raccourci. Dans les deux cas, la même confusion se répète : croire que l’outil modifie les règles fondamentales de la compétence.

Cet article ne propose ni solution clé en main ni position technophile. Il cherche à comprendre pourquoi l’intelligence augmentée ne remplace ni le jugement, ni l’expérience, ni le temps long. Et pourquoi, dans le Québec de 2025–2026, elle agit surtout comme un révélateur des écarts humains déjà présents dans les organisations.

Intelligence augmentée : un révélateur, pas un raccourci

L’IA amplifie ce qui existe déjà, sans corriger l’absence de méthode ou de rigueur.

L’intelligence augmentée repose sur une idée simple : l’IA amplifie les capacités existantes plutôt qu’elle ne les remplace. Cette logique est largement documentée dans les études sur l’automatisation cognitive. Pourtant, dans la pratique organisationnelle, cette distinction est rarement intégrée. Plusieurs employeurs s’attendent à des gains rapides, sans transformation des méthodes de travail ni investissement réel en apprentissage.

Les données de l’ISQ et de Statistique Canada montrent que l’introduction de nouvelles technologies, sans adaptation des processus, produit souvent des effets transitoires, voire nuls. L’IA n’échappe pas à ce constat. Les organisations qui observent des gains durables sont celles qui acceptent un coût initial : temps de formation, révision des rôles, ralentissement temporaire.

L’effet pervers est clair. Sans cadre, l’IA accentue les écarts. Les professionnels déjà structurés progressent. Les autres se sentent rapidement dépassés ou déçus.

Actions clés

-

Arbitrer le temps alloué à l’apprentissage réel de l’IA

-

Prioriser les usages à forte valeur, au détriment des tâches accessoires

-

Accepter une baisse temporaire de cadence

-

Renoncer à une logique de rendement immédiat

Lecture-outil : Le travail invisible — Pierre-Michel Menger

Sans investissement humain soutenu, l’IA accélère surtout les inégalités de compétence internes.

Le temps long demeure la vraie monnaie de la compétence

Aucun outil ne remplace le temps réellement consacré à comprendre et pratiquer.

Qu’il s’agisse d’un ébéniste, d’un comptable ou d’un gestionnaire, la maîtrise découle toujours d’une pratique régulière. Les recherches en psychologie du travail confirment que la compétence experte repose sur l’exposition répétée à des situations complexes. Or, plusieurs organisations abordent l’IA comme un projet ponctuel, délégué ou marginal.

Selon la CNESST, la charge mentale liée aux transformations numériques est en hausse depuis la pandémie. Ajouter l’IA sans retirer d’autres obligations crée un empilement contre-productif. Le temps manque. La pratique devient superficielle.

L’illusion du gain rapide s’effondre alors. L’IA ne compense pas l’absence de disponibilité cognitive.

Actions clés

-

Absorber une réduction volontaire de certaines priorités

-

Renoncer à des indicateurs de performance obsolètes

-

Prioriser la répétition sur la nouveauté

-

Accepter l’inconfort de l’apprentissage prolongé

Lecture-outil : Deep Work — Cal Newport

Sans temps dédié, l’IA devient un bruit de fond, pas un levier.

Plateformes d’IA et limites humaines : pourquoi l’outil n’explique jamais le résultat

Les plateformes diffèrent, mais les écarts de résultats naissent surtout des pratiques humaines.

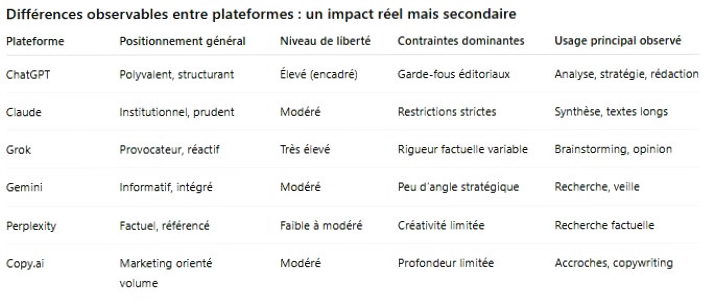

Les comparaisons entre plateformes d’intelligence artificielle occupent une place disproportionnée dans les débats actuels. ChatGPT, Claude, Grok, Gemini. Les discussions portent sur la liberté de réponse, les restrictions, le ton ou les capacités techniques. Ces différences existent. Elles sont observables. Elles influencent certains usages. Mais elles ne permettent pas de comprendre pourquoi, à l’intérieur d’une même organisation, les résultats varient autant d’un professionnel à l’autre.

L’erreur la plus fréquente consiste à attribuer la performance à l’outil plutôt qu’à la pratique. Or, l’IA n’abolit aucune des contraintes fondamentales du travail humain. Elle ne supprime ni la limite de l’attention, ni celle de la mémoire de travail, ni la difficulté à formuler un problème complexe, ni la responsabilité du jugement contextuel. Elle amplifie ce qui est déjà présent.

Ce constat rejoint une loi universelle du travail, bien connue dans les métiers manuels. Un ébéniste qui consacre quarante à soixante heures par semaine à son art développe une intelligence pratique que ni le diplôme ni l’outil ne peuvent remplacer.

À l’inverse, une pratique occasionnelle, même soutenue par des instruments sophistiqués, ne produit jamais la même maîtrise. Cette loi ne disparaît pas dans le travail intellectuel. Elle s’y applique avec la même rigueur.

L’intelligence augmentée révèle ainsi un décalage rarement nommé. Mettre un utilisateur intensif, structuré et rigoureux devant presque n’importe quelle plateforme d’IA produit, dans la durée, de meilleurs résultats qu’un utilisateur occasionnel, même hautement diplômé ou socialement reconnu. Ce n’est pas une opinion. C’est une observation de terrain.

Les différences entre plateformes existent, mais expliquent rarement la qualité du travail produit.

Ces différences influencent le style, la posture et certains usages spécifiques. Elles expliquent des préférences. Elles n’expliquent pas les écarts de qualité substantiels observés dans les productions finales. À pratiques comparables, les résultats convergent. À pratiques inégales, les écarts se creusent, indépendamment de la plateforme choisie.

Pourquoi la limite humaine demeure le facteur déterminant

L’IA progresse vite, mais l’attention, le jugement et la pensée restent profondément limités.

L’humain reste le chaînon critique de toute production assistée par l’IA. Sa capacité d’attention est limitée. Sa mémoire de travail est contrainte. Sa faculté à formuler une question pertinente dépend de son expérience. Son jugement demeure irremplaçable, notamment dans les contextes organisationnels, culturels et institutionnels propres au Québec.

L’IA peut accélérer la réponse. Elle ne peut pas ralentir la pensée à la place de l’utilisateur. Elle ne peut pas compenser l’absence de pratique soutenue. Elle ne peut pas arbitrer à la place du gestionnaire. En ce sens, l’intelligence augmentée ne démocratise pas la compétence. Elle la rend plus visible.

C’est précisément ce point que de nombreux contenus sur l’IA évitent. En se concentrant presque exclusivement sur les outils, ils masquent la responsabilité humaine. Ils entretiennent l’illusion qu’un meilleur choix technologique suffirait à produire de meilleurs résultats.

Actions clés

-

Arbitrer du temps réel pour une pratique régulière et approfondie

-

Prioriser la formulation des problèmes avant la recherche de réponses

-

Accepter les limites cognitives humaines plutôt que les nier

-

Renoncer à l’illusion d’un rendement immédiat par l’outil

Lecture-outil : Thinking, Fast and Slow — Daniel Kahneman

L’IA n’échoue pas par manque de sophistication, mais par absence de pratique humaine soutenue.

Statut académique et performance réelle : un décalage persistant

Le prestige du parcours pèse moins que la capacité à produire des résultats concrets.

Le monde académique valorise la compétition symbolique. Diplômes, institutions, reconnaissance. Ces repères ont longtemps servi de filtres dans les organisations. Or, l’intelligence augmentée remet en question cette hiérarchie implicite. À usage égal, les résultats ne suivent pas nécessairement le prestige du parcours.

Les observations terrain dans les fonctions administratives montrent que les professionnels les plus efficaces avec l’IA sont souvent ceux qui pratiquent régulièrement, indépendamment de leur trajectoire académique. La compétence se mesure désormais dans l’exécution, pas dans l’énoncé.

Ce constat crée une tension identitaire. Certains résistent non par rejet technologique, mais par protection symbolique.

Actions clés

-

Arbitrer entre reconnaissance statutaire et performance observable

-

Prioriser l’évaluation des résultats concrets

-

Accepter une redistribution implicite de la valeur

-

Renoncer à certains raccourcis hiérarchiques

Lecture-outil : La société des diplômes — Marie Duru-Bellat

Quand la valeur se mesure à l’usage, le statut seul ne protège plus.

Gouvernance et responsabilité : le rôle décisif des gestionnaires

Sans arbitrage clair, l’IA circule, mais ne s’intègre jamais vraiment.

L’IA ne s’intègre pas spontanément. Elle exige une gouvernance claire. Or, plusieurs directions hésitent à trancher. Les responsabilités demeurent floues. L’outil circule sans cadre. Cette absence de décision crée une adoption inégale et parfois conflictuelle.

Selon l’Ordre des CRHA, la clarté des attentes managériales constitue un facteur déterminant de réussite des transformations numériques. Sans arbitrage explicite, les équipes bricolent.

L’IA devient alors un sujet de débat, pas un outil de travail.

Actions clés

-

Prioriser des règles d’usage explicites

-

Assumer les choix d’implantation

-

Absorber les résistances sans les nier

-

Renoncer à une neutralité illusoire

Lecture-outil : Le courage managérial — Isabelle Barth

L’IA amplifie ce qui est là — y compris nos faiblesses.

À retenir...

L’intelligence augmentée ne transforme pas le travail en profondeur. Elle met en lumière ce qui était déjà là. Le temps investi, la rigueur, la capacité à structurer des problèmes complexes. Les organisations québécoises qui espèrent des gains rapides sans remise en question risquent la déception.

Les lois fondamentales du travail demeurent intactes. La compétence ne s’achète pas. Elle se construit. L’IA ne fait qu’accélérer la visibilité des écarts existants. Ceux qui pratiquent progressent. Ceux qui survolent stagnent.

Pour les décideurs, la responsabilité est claire. Il ne s’agit pas de choisir le bon outil, mais de créer les conditions humaines de son usage. Cela implique des arbitrages difficiles. Réduire certaines priorités. Accepter des coûts temporaires. Assumer des tensions internes.

L’inaction n’est pas neutre. Elle favorise les usages superficiels, renforce les résistances et accentue les déséquilibres. À l’inverse, une gouvernance assumée permet de transformer l’IA en véritable levier d’intelligence augmentée.

Le Québec de 2025–2026 n’a pas besoin de discours rassurants. Il a besoin de lucidité.

L’outil est là. Les lois humaines, elles, n’ont jamais changé.

FAQ sur l’intelligence augmentée

- L’IA remplace-t-elle certaines compétences humaines ? Non. Elle accentue surtout les écarts entre compétences existantes.

- Faut-il former tout le monde à l’IA ? Former sans dégager du temps réel produit peu d’effets durables.

- Le choix de l’outil est-il déterminant ? À usages comparables, les écarts de performance restent majoritairement humains.

- Pourquoi certains professionnels rejettent-ils l’IA ? Souvent par crainte de perte de statut, plus que par enjeu technique.

Références

-

Institut de la statistique du Québec (ISQ)

-

Statistique Canada — Productivité du travail

-

CNESST – Charge mentale et organisation du travail

-

Ordre des CRHA — Transformation numérique et RH

-

IRPP – Automatisation et travail intellectuel

Tendances manufacturières!